Emotionen in Stimmen erkennen mit PyTorch und wav2vec2

Why take this course?

🎧 Kurs Titel: Emotionen in Stimmen erkennen mit PyTorch und wav2vec2

Kurs Headline:

Entfessel die Macht der Sprache – Klassifikation von Audiodaten mit Huggingface Transformers

KurzDescription:

Steh vor der Herausforderung, Emotionen in sprachlichen Audiodateien zu erkennen? In diesem intensiven Kurs lernen Sie, wie Sie ein leistungsfähiges Modell mit PyTorch und Huggingface Transformers trainieren, um sieben verschiedene Emotionen in menschlicher Sprache zu klassifizieren. Wir verwenden den berühmten wav2vec2-Modell und bauen darauf auf, um Ihre KI darin auszurüsten, Stimmungsnuancen in Audioaufnahmen zu erkennen.

Detailed Curriculum:

Einführung & Datensatz Vorbereitung:

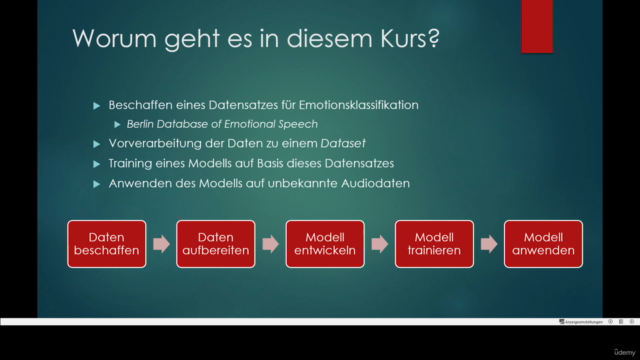

- Vorstellung des Kurskurses und Ziele.

- Besorgung und Vorbereitung des Berlin Database of Emotional Speech, einer freien Sammlung von Audioaufnahmen.

- Anleitung zur Formatierung und Labeling der Audiodateien.

- Erstellung eines benutzerdefinierten Dataset in PyTorch.

Modellbasis & Training:

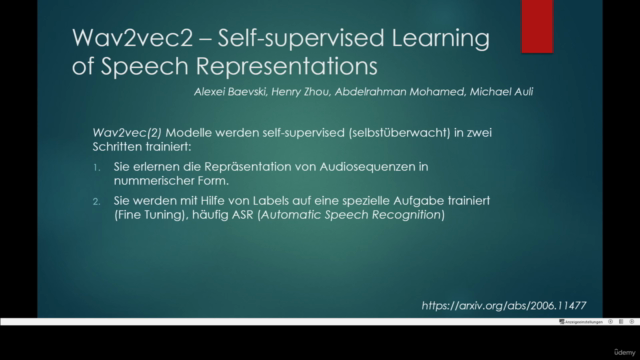

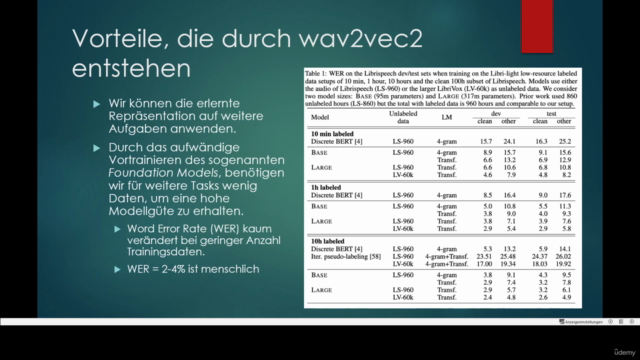

- Einführung in wav2vec2 als Foundation Modell für Audio Classification.

- Konfiguration von Huggingface Transformers für den Einsatz mit Audio-Daten.

- Hinzufügen eines Classification Head zum Modell und Erklärung des Training Prozesses.

- Detaillierte Schritt-an-Schritt Anleitung zur Model Fine-Tuning.

Inference & Anwendung:

- Entwicklung eines Inference-Scripts für das eingetrainte Modell.

- Anwendung des Modells auf neue Audioaufnahmen und Interpretation der Ergebnisse.

Evaluation & Optimierung:

- Bewertung der Performance des Trainingsmodells.

- Diskussion potenzieller Verbesserungen und Optimierungsstrategien.

Veröffentlichung & Gemeinschaft:

- Anleitung zur Veröffentlichung Ihres fertigen Modells auf dem Huggingface Hub.

- Tipps und Best Practices für die Interaktion mit der KI-Gemeinschaft und das Einholen von Feedback.

Was Sie vom Kurs mitnehmen werden:

- Ein tiefes Verständnis für das Trainieren von Modellen zur Klassifizierung von Audiodaten.

- Erfahrung im Umgang mit den Huggingface Transformers und PyTorch.

- Fähigkeiten, um Emotionen in sprachlichen Audioaufnahmen zu erkennen und zu interpretieren.

- Ein veröffentlichungsfähiges Projekt, das Sie stolz auf Ihr Profil oder auf Huggingface teilen können.

Voraussetzung: Grundkenntnisse in Python und ein grundlegendes Verständnis für Deep Learning Konzepte.

Komm und lerne, wie Sie mit der Kraft der Sprache kommunizieren können – auf eine Weise, die nur KI-basierte Audioanalyse ermöglicht! 🤖🎙️

Course Gallery

Loading charts...