Convolutional Neural Networks - Hinter den Kulissen

Why take this course?

Die von Ihnen skizzierte Vorstellung von Convolutional Neural Networks (CNNs) und insbesondere Residual Nets (ResNets) ist ziemlich genau. Ich ergänze und vertiefe einige Punkte, um die Erklärung zu vervollständigen:

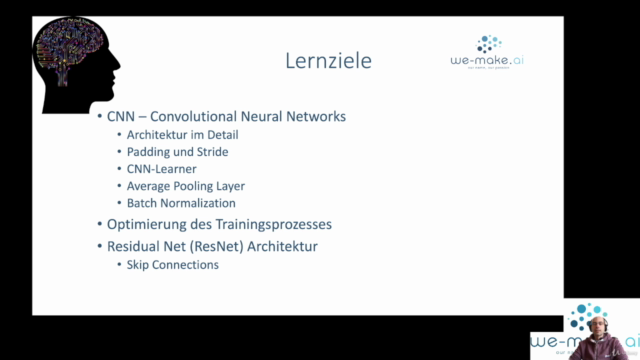

Convolutional Neural Networks (CNNs):

Architektur:

- Convolutional Layer (Conv Layer): Verantwortlich für das extrahieren von räumlichen Eigenschaften aus Bilddaten durch Filter (Kerne). Jeder Filter kann als feature detector dienen, der z.B. Kanten, Farbverläufe oder Texturen erkennt.

- Pooling Layer (Pool Layer): Reduziert die Dimensionen des Volumens (breite, höhe, Kanäle) durch Subsampling wie Max-Pooling oder Average-Pooling. Dies reduziert den Computationsaufwand und verbessert die Invarianz gegenüber Skalierung und Position.

- Fully Connected Layer (Dense Layer): Diese Schicht kommt nach den Conv und Pooling Layern, wo alle neuronale Informationen des vorherigen Schichts verarbeitet werden. Sie sind oft in der Endphase des CNNs zu finden, wo die Features in eine Klassifikation oder Ausgabe umgewandelt werden.

- Activation Layer: Aktivierungsfunktionn wie ReLU (Rectified Linear Unit) oder Sigmoid aktivieren oder deaktivieren die neuronale Aktivität, was dazu beiträgt, komplexe Muster zu lernen.

Residual Networks (ResNets):

Erfindung und Vorteile:

- Residual Blocks: Diese Blocks überwinden das "vanishing gradient" Problem bei sehr tiefen Netzen, indem sie die Identität als eine "Shortcut" innerhalb des Netzes erlauben. Dies ermöglicht den Gradienten über viele Ebenen des Netzes zu propagieren und das Training tiefer Netze zu erleichtern.

- Skip Connections: Die direkten Verbindungen zwischen Layerinneren, die die Identität repräsentieren, helfen dabei, den Backpropagation durchgradient through time (BPTT) zu ermöglichen und das Training von sehr tiefen Netzen zu erleichtern.

- Depth: ResNets können deutlich tiefer sein als herkömmliche CNNs ohne ein signifikantes Risiko eines "gradient decay" oder einer Verwässerung der Informationen im Netz.

Training von Residual Nets:

Hauptschritte:

- Initialisierung: Starte mit einer kleinen, leicht trainierten CNN als Basis für die residual Blocks.

- Training: Verwende Backpropagation und eine Optimizer wie SGD (Stochastic Gradient Descent) oder Adam, um das Netz zu trainieren. ResNets profitieren hierbei von Techniken wie Dropout und Data Augmentation, um Überanpassung (Overfitting) zu vermeiden.

- Optimierung: Optimiere die Hyperparameter des Modells (z.B. Lernrate, Batch-Size, Anzahl der Epochs), um die Genauigkeit des Modells zu verbessern.

- Evaluation: Teste das trainierte Modell auf einem Validierungsset (separatem Datensatz, der nicht zum Training verwendet wurde) zur Beurteilung seiner allgemeingültigen Fähigkeiten.

Anwendungen:

Residual Networks haben sich als sehr mächtige Werkzeuge in den Bereichen Bilderkennung, Sprachverständnis und anderen Mustererkennungsaufgaben erwiesen. Sie sind Bestandteil von Modellen wie dem Microsoft ResNet (R-CNN) für Objekterkennung oder BERT (Bidirectional Encoder Representations from Transformers), das in Natural Language Processing (NLP) eingesetzt wird.

Fazit:

Die Entwicklung von Residual Nets durch Kaiming He, Shaoqing Ren und Jia Yang im Jahr 2015 war ein bedeutender Durchbruch, der die Grenzen von CNNs erweiterte und den Weg für noch tiefere und mächtigere neural netzbasierte Modelle ebnete. Sie zeigte, dass es möglich ist, Netze mit hunderten von Layern zu trainieren, ohne dass die Leistung stark abnimmt oder das Training viel zu schwierig wird.

Course Gallery

Loading charts...